|

| image from: xkcd.com |

조금 전, 학교 전산실에서 "통계 표본크기 산출" 주제의 세미나를 듣고 왔다.

???: "요즘 high IF journal에 논문 섭미션할때 그냥 p-value만 들이대면 리뷰오고 통계로 까이고 그러면 리젝받고. 그러면서도 리뷰어에게 허벌나게 치욕적 비난받고 낮은 IF 저널에 냅니다. 온코타겟을 살"(...)

결국 관건은, 통계 검정력을 위한 표본 숫자를 정확하게 계산해서 제시해야 논문 피어 리뷰어도 납득할거라는 얘기인듯 하다. 최근 들어 의학 및 심리학 논문들에서 재현성 위기 (https://en.wikipedia.org/wiki/Replication_crisis) 때문에 엄청 난리였는데, 잘못된 통계 검증 때문에 연구 자체의 유의성이 잘못 설정되어 실제로 그 연구들을 다시 수행해 보았을 경우 재현성이 나오지 않는 경우가 엄청 많았다고 한다. 특히 생물학의 경우 조사 대상의 약 80% 가까이 다른 논문의 방법을 따라했을 경우 결과 재현에 실패한 경험이 있고, 약 60%의 연구자는 심지어 본인의 실험 재현에도 실패한 적이 있다고 하더라(...).

그 이유로 생각해볼 만한 것이, 통계적 연관성이 인과성을 대표하지 않기 때문에 외부 조건에 따라 다른 결과가 나올 경우도 있겠지만, 많은 경우 통계적 계산을 잘못 적용하거나 너무 약한 통계검정을 사용하여 잘못된 통계치를 근거로 유의성을 주장했기 때문인 것으로 보인다.

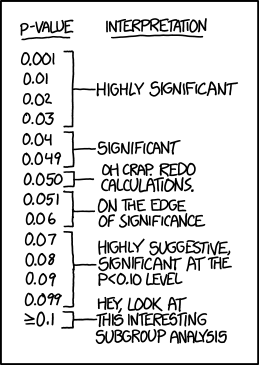

그래서 요즘같은 경우에는 p-value (귀무가설이 참일 경우에도 이를 기각하는 결과가 나타날 확률) 만으로는 부족하고, 통계적 검정력 및 그에 입각한 표본 갯수 설정 과정도 요구하는 저널이 많아지고 있다. 앞으로 이에 대해 많이 공부해야 할듯 하다.

[Sample size 결정을 위한 effect size 결정]

Cohen's d : 표준화된 효과크기=실제 효과크기/표준편차

<0.4: 작은 효과크기

0.4-0.7: 중간 효과크기

>0.7: 큰 효과크기

여기서 G-Power 라는 프로그램이 실험군당 표본 수 결정을 계산하는 데 도움이 된다고 한다. (https://en.wikipedia.org/wiki/G*Power)

참고:

https://cs.kaist.ac.kr/colloquium/files/20161031.pdf

댓글 없음:

댓글 쓰기